- Перевод

Все мы помним со школы мучительные упражнения в арифметике. На то, чтобы перемножить числа вроде 3 752 и 6 901 при помощи карандаша и бумаги, уйдёт не меньше минуты. Конечно же, сегодня, когда под рукой у нас телефоны, мы быстро можем проверить, что результат нашего упражнения должен равняться 25 892 552. Процессоры современных телефонов могут выполнять более 100 млрд таких операций в секунду. Более того, эти чипы потребляют всего несколько ватт, что делает их гораздо эффективнее наших медленных мозгов, потребляющих 20 Вт и требующих гораздо большего времени на достижение того же результата.

Конечно же, мозг эволюционировал не для того, чтобы заниматься арифметикой. Поэтому у него это получается плохо. Но он прекрасно справляется с обработкой постоянного потока информации, идущего от нашего окружения. И он реагирует на неё – иногда быстрее, чем мы можем это осознать. И неважно, сколько энергии будет потреблять обычный компьютер – он с трудом будет справляться с тем, что легко даётся мозгу – например, с пониманием языка или с бегом по лестнице.

Если бы могли создать машины, вычислительные способности и энергетическая эффективность которых были бы сравнимы с мозгом, то всё поменялось бы кардинально. Роботы бы ловко двигались в физическом мире и общались бы с нами на естественном языке. Крупномасштабные системы собирали бы огромные объёмы информации по бизнесу, науке, медицине или управлению государством, обнаруживая новые закономерности, находя причинно-следственные связи и делая предсказания. Умные мобильные приложения типа Siri и Cortana могли бы меньше полагаться на облака. Такая технология могла бы позволить нам создать устройства с небольшим энергопотреблением, дополняющие наши чувства, обеспечивающие нас лекарствами и эмулирующие нервные сигналы, компенсируя повреждение органов или паралич.

Но не рано ли ставить себе такие смелые цели? Не слишком ограничено ли наше понимание мозга для того, чтобы мы могли создавать технологии, работающие на основе его принципов? Я считаю, что эмуляция даже простейших особенностей нервных контуров может резко улучшить работу множества коммерческих приложений. Насколько точно компьютеры должны копировать биологические детали строения мозга, чтобы приблизиться к его уровню быстродействия – это пока открытый вопрос. Но сегодняшние системы, вдохновлённые строением мозга, или нейроморфные, станут важными инструментами для поисков ответа на него.

Ключевая особенность обычных компьютеров – физическое разделение памяти, хранящей данные и инструкции, и логики, обрабатывающей эту информацию. В мозгу такого разделения нет. Вычисления и хранение данных происходят одновременно и локально, в обширной сети, состоящей из примерно 100 млрд нервных клеток (нейронов) и более 100 трлн связей (синапсов). По большей части мозг определяется этими связями и тем, как каждый из нейронов реагирует на входящий сигнал других нейронов.

Говоря об исключительных возможностях человеческого мозга, обычно мы имеем в виду недавнее приобретение долгого эволюционного процесса – неокортекс (новую кору). Этот тонкий и крайне складчатый слой формирует внешнюю оболочку мозга и выполняет очень разные задачи, включающие обработку поступающей от чувств информации, управление моторикой, работу с памятью и обучение. Такой широкий спектр возможностей доступен довольно однородной структуре: шесть горизонтальных слоёв и миллион вертикальных столбиков по 500 мкм шириной, состоящих из нейронов, интегрирующих и распределяющих информацию, закодированную в электрических импульсах, вдоль растущих из них усиков – дендритов и аксонов.

Как у всех клеток человеческого тела, у нейрона существует электрический потенциал порядка 70 мВ между внешней поверхностью и внутренностями. Это мембранное напряжение изменяется, когда нейрон получает сигнал от других связанных с ним нейронов. Если мембранное напряжение поднимается до критической величины, он формирует импульс, или скачок напряжения, длящийся несколько миллисекунд, величиной порядка 40 мВ. Этот импульс распространяется по аксону нейрона, пока не доходит до синапса – сложной биохимической структуры, соединяющей аксон одного нейрона с дендритом другого. Если импульс удовлетворяет определённым ограничениям, синапс преобразует его в другой импульс, идущий вниз по ветвящимся дендритам нейрона, получающего сигнал, и меняет его мембранное напряжение в положительную или отрицательную сторону.

Связность – критическая особенность мозга. Пирамидальный нейрон – особенно важный тип клеток человеческого неокортекса – содержит порядка 30 000 синапсов, то есть 30 000 входных каналов от других нейронов. И мозг постоянно приспосабливается. Нейрон и свойства синапса – и даже сама структура сети – постоянно изменяются, в основном под воздействием входных данных с органов чувств и обратной связи окружающей среды.

Современные компьютеры общего назначения цифровые, а не аналоговые; мозг классифицировать не так-то просто. Нейроны накапливают электрический заряд, как конденсаторы в электронных схемах. Это явно аналоговый процесс. Но мозг использует всплески в качестве единиц информации, а это в основе своей двоичная схема: в любое время в любом месте всплеск либо есть, либо его нет. В терминах электроники, мозг – система со смешанными сигналами, с локальными аналоговыми вычислениями и передачей информацией при помощи двоичных всплесков. Поскольку у всплеска есть только значения 0 или 1, он может пройти большое расстояние, не теряя этой основной информации. Он также воспроизводится, достигая следующего нейрона в сети.

Ещё одно ключевое отличие мозга и компьютера – мозг справляется с обработкой информации без центрального тактового генератора, синхронизирующего его работу. Хотя мы и наблюдаем синхронизирующие события – мозговые волны – они организуются сами, возникая как результат работы нейросетей. Что интересно, современные компьютерные системы начинают перенимать асинхронность, свойственную мозгу, чтобы ускорить вычисления, выполняя их параллельно. Но степень и цель параллелизации двух этих систем крайне различны.

У идеи использования мозга в качестве модели для вычислений глубокие корни. Первые попытки были основаны на простом пороговом нейроне , выдающем одно значение, если сумма взвешенных входящих данных превышает порог, и другое – если не превышает. Биологический реализм такого подхода, задуманного Уорреном Маккалохом и Уолтером Питтсом в 1940-х, весьма ограничен. Тем не менее, это был первый шаг к применению концепции срабатывающего нейрона в качестве элемента вычислений.

В 1957 году Фрэнк Розенблатт предложил другой вариант порогового нейрона, перцептрон . Сеть из взаимосвязанных узлов (искусственных нейронов) составляется слоями. Видимые слои на поверхности сети взаимодействуют с внешним миром в качестве входов и выходов, а скрытые слои, находящиеся внутри, выполняют все вычисления.

Розенблатт также предложил использовать основную особенность мозга: сдерживание. Вместо того, чтобы складывать все входы, нейроны в перцептроне могут вносить и отрицательный вклад. Эта особенность позволяет нейросетям использовать единственный скрытый слой для решения задач на XOR в логике, в которых выход равен истине, если только один из двух двоичных входов истинный. Этот простой пример показывает, что добавление биологического реализма может добавлять и новые вычислительные возможности. Но какие функции мозга необходимы для его работы, а какие – бесполезные следы эволюции? Никто не знает.

Нам известно, что впечатляющих вычислительных результатов можно добиться и без попыток создать биологический реализм. Исследователи глубинного обучения продвинулись очень далеко в деле использования компьютеров для анализа крупных объёмов данных и выделения определённых признаков из сложных изображений. Хотя созданные ими нейросети обладают большим количеством входов и скрытых слоёв, чем когда бы то ни было, они всё-таки основаны на крайне простых моделях нейронов. Их широкие возможности отражают не биологический реализм, а масштаб содержащихся в них сетей и мощность используемых для их тренировки компьютеров. Но сетям с глубинным обучением всё ещё очень далеко до вычислительных скоростей, энергетической эффективности и возможностей обучения биологического мозга.

Огромный разрыв между мозгом и современными компьютерами лучше всего подчёркивают крупномасштабные симуляции мозга. За последние годы было сделано несколько таких попыток, но все они были жёстко ограничены двумя факторами: энергией и временем симуляции. К примеру, рассмотрим симуляцию , проведённую Маркусом Дайсманом с его коллегами несколько лет назад при использовании 83 000 процессоров на суперкомпьютере К в Японии. Симуляция 1,73 млрд нейронов потребляла в 10 млрд раз больше энергии, чем эквивалентный участок мозга, хотя они и использовали чрезвычайно упрощённые модели и не проводили никакого обучения. И такие симуляции обычно работали более чем в 1000 раз медленнее реального времени биологического мозга.

Почему же они такие медленные? Симуляция мозга на обычных компьютерах требует вычисления миллиардов дифференциальных уравнений, связанных между собой, и описывающих динамику клеток и сетей: аналоговые процессы вроде перемещения заряда по клеточной мембране. Компьютеры, использующие булевскую логику – меняющую энергию на точность – и разделяющие память и вычисления, крайне неэффективно справляются с моделированием мозга.

Эти симуляции могут стать инструментом познания мозга, передавая полученные в лаборатории данные в симуляции, с которыми мы можем экспериментировать, а затем сравнивать результаты с наблюдениями. Но если мы надеемся идти в другом направлении и использовать уроки нейробиологии для создания новых вычислительных систем, нам необходимо переосмыслить то, как мы разрабатываем и создаём компьютеры.

Нейроны в кремнии.

Копирование работы мозга при помощи электроники может быть более выполнимым, чем это кажется на первый взгляд. Оказывается, что на создание электрического потенциала в синапсе тратится примерно 10 фДж (10 -15 джоулей). Затвор металл-оксид-полупроводникового (МОП) транзистора, значительно более крупного и потребляющего больше энергии, чем те, что используются в ЦП, требует для заряда лишь 0,5 фДж. Получается, что синаптическая передача эквивалентна зарядке 20 транзисторов. Более того, на уровне устройств биологические и электронные схемы не так уж сильно различаются. В принципе можно создать структуры, подобные синапсам и нейронам, из транзисторов, и соединить их так, чтобы получить искусственный мозг, не поглощающий таких вопиющих объёмов энергии.

Идея о создании компьютеров при помощи транзисторов, работающих как нейроны, появилась в 1980-х у профессора Карвера Мида из Калтеха. Одним из ключевых аргументов Мида в пользу «нейроморфных» компьютеров было то, что полупроводниковые устройства могут, работая в определённом режиме, следовать тем же физическим законам, что и нейроны, и что аналоговое поведение можно использовать для расчётов с большой энергоэффективностью.

Группа Мида также изобрела платформу для нейрокоммуникаций, в которой всплески кодируются только их адресами в сети и временем возникновения. Эта работа стала новаторской, поскольку она первой сделала время необходимой особенностью искусственных нейросетей. Время – ключевой фактор для мозга. Сигналам нужно время на распространение, мембранам – время на реакцию, и именно время определяет форму постсинаптических потенциалов.

Несколько активных сегодня исследовательских групп, например, группа Джиакомо Индивери из Швейцарской высшей технической школы и Квабены Боахен из Стэнфорда, пошли по стопам Мида и успешно внедрили элементы биологических корковых сетей. Фокус в том, чтобы работать с транзисторами при помощи тока низкого напряжения, не достигающего их порогового значения, создавая аналоговые схемы, копирующие поведение нервной системы, и при этом потребляющие немного энергии.

Дальнейшие исследования в этом направлении могут найти применение в таких системах, как интерфейс мозг-компьютер. Но между этими системами и реальным размером сети, связности и способностью к обучению животного мозга существует огромный разрыв.

Так что в районе 2005 году три группы исследователей независимо начали разрабатывать нейроморфные системы, существенно отличающиеся от изначального подхода Мида. Они хотели создать крупномасштабные системы с миллионами нейронов.

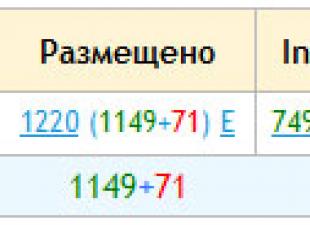

Ближе всех к обычным компьютерам стоит проект SpiNNaker , руководимый Стивом Фёрбером из Манчестерского университета. Эта группа разработала собственный цифровой чип, состоящий из 18 процессоров ARM, работающих на 200 МГц – примерно одна десятая часть скорости современных CPU. Хотя ядра ARM пришли из мира классических компьютеров, они симулируют всплески, отправляемые через особые маршрутизаторы, разработанные так, чтобы передавать информацию асинхронно – прямо как мозг. В текущей реализации, являющейся частью проекта Евросоюза «Человеческий мозг» , и завершённой в 2016 году, содержится 500 000 ядер ARM. В зависимости от сложности модели нейрона, каждое ядро способно симулировать до 1000 нейронов.

Чип TrueNorth, разработанный Дармендра Мода и его коллегами из Исследовательской лаборатории IBM в Альмадене, отказывается от использования микропроцессоров как вычислительных единиц, и представляет собой на самом деле нейроморфную систему, в которой переплелись вычисления и память. TrueNorth всё равно остаётся цифровой системой, но основана она на специально разработанных нейроконтурах, реализующих определённую модель нейрона. В чипе содержится 5,4 млрд транзисторов, он построен по 28-нм технологии Samsung КМОП (комплементарная структура металл-оксид-полупроводник). Транзисторы эмулируют 1 млн нейроконтуров и 256 млн простых (однобитных) синапсов на одном чипе.

Я бы сказал, что следующий проект, BrainScaleS , отошёл довольно далеко от обычных компьютеров и приблизился к биологическому мозгу. Над этим проектом работали мы с моими коллегами из Гейдельбергского университета для европейской инициативы «Человеческий мозг». BrainScaleS реализует обработку смешанных сигналов. Он комбинирует нейроны и синапсы, в роли которых выступают кремниевые транзисторы, работающие как аналоговые устройства с цифровым обменом информацией. Полноразмерная система состоит из 8-дюймовых кремниевых подложек и позволяет эмулировать 4 млн нейронов и 1 млрд синапсов.

Система может воспроизводить девять различных режимов срабатывания биологических нейронов, и разработана в тесном сотрудничестве с нейробиологами. В отличие от аналогового подхода Мида, BrainScaleS работает в ускоренном режиме, его эмуляция в 10 000 раз быстрее реального времени. Это особенно удобно для изучения процесса обучения и развития.

Обучение, скорее всего, станет критическим компонентом нейроморфных систем. Сейчас чипы, сделанные по образу мозга, а также нейросети, работающие на обычных компьютерах, тренируются на стороне при помощи более мощных компьютеров. Но если мы хотим использовать нейроморфные системы в реальных приложениях – допустим, в роботах, которые должны будут работать бок о бок с нами, они должны будут уметь учиться и адаптироваться на лету.

Во втором поколении нашей системы BrainScaleS мы реализовали возможность обучения, создав на чипе «обработчики гибкости». Они используются для изменения широкого спектра параметров нейронов и синапсов. Эта возможность позволяет нам точно подстраивать параметры для компенсации различий в размере и электрических свойствах при переходе от одного устройства к другому – примерно как сам мозг подстраивается под изменения.

Три описанных мной крупномасштабных системы дополняют друг друга. SpiNNaker можно гибко настраивать и использовать для проверки разных нейромоделей, у TrueNorth высока плотность интеграции, BrainScaleS разработана для постоянного обучения и развития. Поиски правильного способа оценки эффективности таких систем пока продолжаются. Но и ранние результаты многообещающие. Группа TrueNorth от IBM недавно подсчитала, что синаптическая передача в их системе отнимает 26 пДж. И хотя это в 1000 раз больше энергии, требующейся в биологической системе, зато это почти в 100 000 раз меньше энергии, уходящей на передачу в симуляции на компьютерах общего назначения.

Мы всё ещё находимся на ранней стадии понимания того, что могут делать такие системы и как их применять к решению реальных задач. Одновременно мы должны найти способы комбинировать множество нейроморфных чипов в крупные сети с улучшенными возможностями к обучению, при этом понижая энергопотребление. Одна из проблем – связность: мозг трёхмерный, а наши схемы – двумерные. Вопрос трёхмерной интеграции схем сейчас активно изучают, и такие технологии могут нам помочь.

Ещё одним подспорьем могут стать устройства, не основанные на КМОП – мемристоры или PCRAM (память с изменением фазового состояния). Сегодня веса, определяющие реакцию искусственных синапсов на входящие сигналы, хранятся в обычной цифровой памяти, отнимающей большую часть кремниевых ресурсов, необходимых для построения сети. Но другие виды памяти могут помочь нам уменьшить размеры этих ячеек с микрометровых до нанометровых. И основной трудностью современных систем будет поддержка различий между разными устройствами. Для этого смогут помочь принципы калибровки, разработанные в BrainScaleS.

Мы только начали свой путь по дороге к практичным и полезным нейроморфным системам. Но усилия стоят того. В случае успеха мы не только создадим мощные вычислительные системы; мы даже можем получить новую информацию о работе нашего собственного мозга.

На наших глазах разворачивается настоящая война стремительно развивающихся технологий и мозга человека. И вот мы уже слышим, что борьба «машина — человек» завершится отнюдь не в пользу последнего. Причем в ближайшее время. Насколько правомерна идея замены «несовершенного биологического компьютера более совершенным электронным» и чем отличается мозг человека от самого современного устройства? Размышляет психолог, сертифицированный тренер по методам мышления Эдварда де Боно Андрей Беспалов.

Многие думают, что с прогрессом технологий необходимость запоминать информацию сама собой отпадет. Ведь исчезла же нужда в устном счете с появлением калькуляторов! Уже сейчас любые сведения можно «нагуглить» за несколько минут, а лозунги в стиле «ваш мозг — самый мощный компьютер» теряют актуальность. Компьютер/облако/«Гугл» способны запоминать настолько лучше и больше, чем мы, что нет никакого смысла с ними соревноваться. Но действительно ли наш мозг — это ЭВМ в голове? И почему даже самая продвинутая техника не сможет сравниться с работой серого вещества человека?

Иерархия памяти

Обратимся к простому примеру. Все работающие на компьютере хорошо знают, что файл с инструкцией «как сделать оглавление в Word» выглядит примерно так: «Обозначьте в документе место, куда следует вставить оглавление, откройте вкладку “Ссылки”, нажмите кнопку “Оглавление”» — и так далее. Но в голове все это происходит иначе. В противном случае, если бы друг спросил меня по телефону о том, как сделать автооглавление, я бы сразу ответил. Но я говорю: «Подожди, сейчас программу открою», и только после того, как увижу Word перед собой, могу вспомнить, что нужно делать.

Вся загадка кроется в том, что в отличие от файлов, которые записываются и считываются линейно, воспоминания в мозгу хранятся иерархически. Что происходит, когда человек видит, например, букву Н? Изображение попадает на сетчатку, а оттуда — в первичную зрительную кору, которая занимается узнаванием простых образов: две вертикальных палочки, одна горизонтальная. Данные об этих палочках она передает во вторичную зрительную кору, которая складывает из них более сложный паттерн («Н») и передает результат в следующую зону, где буквы, полученные из разных участков вторичной зрительной коры, соединяются в слова и передаются «наверх».

Сила предсказания

Кора мозга поделена на множество зон, по которым постоянно движется информация, причем не только вверх по иерархии, но и вниз. Мозг человека настолько эффективен, утверждает Джефф Хокинс в книге «Об интеллекте», что умеет предсказывать будущие события, основываясь на опыте, хранящемся в памяти. Для того чтобы произвести определенное действие (например, поймать мяч), мозг не должен долго вычислять — ему достаточно вспомнить, как он действовал раньше, и на этом основании предсказать полет мяча и скоординировать свои движения. Цепи нейронов, находящиеся в коре, образуют иерархическую структуру, в которой высшие уровни постоянно посылают информацию к нижним уровням. Это позволяет сравнивать поступающую последовательность образов с последовательностями из предыдущего опыта. Так, на основании слов «Давным-давно, много лет…» можно предсказать, что следующими словами будут «…тому назад».

Хокинс сравнивает работу нашего мозга с иерархией военных команд: «Генералы на армейской верхушке говорят: “Выдвинуть войска во Флориду на зиму”». Простая высокоуровневая команда разворачивается в более детальные по последовательности команды, спускаясь вниз по уровням иерархии. И тысячи отдельных структур выполняют десятки тысяч действий, приводящих в результате к перемещению войск. Отчеты о том, что происходит, генерируются на каждом уровне и поступают наверх до тех пор, пока генерал не получит последний доклад: «Перемещение произошло успешно». Генерал не вникает в детали.

Вспомнить все

В отличие от мозга, в компьютере за «память» отвечают два очень разных устройства: HDD (винт) и RAM (оперативка). Казалось бы, аналогия налицо: винт — кора, а оперативка — гиппокамп. Но присмотримся повнимательнее к тому, как система работает. Изначально новая информация поступает в гиппокамп через зоны коры. Если больше мы с этой информацией не столкнемся, гиппокамп постепенно забывает ее. И чем чаще мы что-то вспоминаем, тем прочнее становятся связи в коре до тех пор, пока гиппокамп не «передаст ей все полномочия» касательно этого паттерна. Этот процесс называется «консолидацией памяти» и может длиться до двух лет. Пока он не закончен, говорить о том, что информация надежно хранится в долгосрочной памяти, рановато.

Попытайтесь в унылую осень вспомнить свой отпуск: как лежали на морском пляже и смотрели на песок. Присмотритесь: вы уже различаете в нем отдельные песчинки, камушки, осколки ракушек. Очень сомнительно, что вы на самом деле это помните, — в какой-то момент в этот образ вклинивается фантазия и услужливо предоставляет нужные детали. Но в какой именно период воспоминания и фантазии сливаются в единое целое – определить невозможно.

Таким образом, любая информация, которая возвращается из долгосрочной памяти в рабочую, приводится в соответствие изменившемуся контексту и текущим задачам, а потом консолидируется в обновленном виде. И каждый раз, когда мы вспоминаем события прошлого, это уже воспоминание не о самом событии, а о последней «редакции» мозга. Варианта «открыть файл для просмотра» у нашей памяти просто нет — любое обращение к ней предполагает определенное изменение.

Память как искусство

В компьютере удалить или сохранить файл — действия противоположные, для человеческой памяти — это две стороны одной медали.

«Для нашего интеллекта забвение составляет такую же важную функцию, как и запоминание

, — писал Уильям Джеймс больше ста лет назад. — Если бы мы помнили решительно все, то были бы в таком же безвыходном положении, как если бы не помнили ничего. Припоминание некоего события требовало бы столько же времени, сколько и само это событие

».

Да, возможно, компьютер способен лучше сохранять информацию, но он не способен так же хорошо ее забывать. Мы ведь забываем далеко не случайно — воспоминание очищается от шелухи (которую, как в примере с песком, при необходимости можно будет заполнить воображением) и сохраняется лишь значимый каркас. А выявить и обозначить этот каркас нам помогает размышление.

Да, возможно, компьютер способен лучше сохранять информацию, но он не способен так же хорошо ее забывать. Мы ведь забываем далеко не случайно — воспоминание очищается от шелухи (которую, как в примере с песком, при необходимости можно будет заполнить воображением) и сохраняется лишь значимый каркас. А выявить и обозначить этот каркас нам помогает размышление.

Именно поэтому Уильям Джеймс утверждает, что «искусство помнить – это искусство мыслить». Запомнить – это значит связать новую информацию с той, которую мы уже знаем. Чем больше человек помнит, тем проще остаться в памяти новому. А лучший способ что-то запомнить — упорное размышление о поступившей информации.

Как не утонуть в море фактов

Какие же напрашиваются выводы? Мы можем только порадоваться возможностям собственного мозга. Наша память, в отличие от компьютерной, не просто склад информации, а неотъемлемая часть мышления. А это колоссальный шанс для развития.

Для восполнения знаний можно запросить в «Гугле» любую информацию, но, чтобы сделать это, необходимо понять, что конкретно вы не знаете. Это как пазл — когда вокруг недостающего кусочка картинка уже собрана, очень просто понять, что именно нужно найти. Но когда все кусочки в беспорядке, даже непонятно, с чего начать. В этом случае «Гугл» способен лишь утопить нас в море фактов, но никак не приблизить к их пониманию. И только мозг подсказывает, каких фрагментов не хватает. Таким образом, нам остается только регулярно загружать себя новыми, интересными заданиями, чтобы поддерживать мозг в прекрасной форме.

Центральная идея работ знаменитого Рэя Курцвейла - искусственный интеллект, который со временем будет властвовать во всех сферах жизни людей. В своей новой книге «Эволюция разума» Курцвейл раскрывает бесконечный потенциал возможностей в сфере обратного проектирования человеческого мозга.

В той же статье Тьюринг поведал о другом неожиданном открытии, касающемся неразрешимых задач. Неразрешимые задачи - это те, что хорошо описываются единственным решением (которое, как можно показать, существует), но (как тоже можно показать) не могут быть решены никакой машиной Тьюринга (то есть вообще никакой машиной). Представление о существовании таких задач в корне противоречит сформировавшейся к началу XX в. догме о том, что все проблемы, которые можно сформулировать, являются решаемыми. Тьюринг показал, что число неразрешимых задач не меньше числа разрешимых задач. В 1931 г. к такому же выводу пришел Курт Гедель, сформулировавший «теорему о неполноте». Такая странная ситуация: мы можем сформулировать задачу, можем доказать, что у нее существует единственное решение, но при этом знаем, что никогда не сможем это решение найти.

Тьюринг показал, что вычислительные машины действуют на основании очень простого механизма. Поскольку машина Тьюринга (и, следовательно, любой компьютер) может определять свою дальнейшую функцию на основе полученных ею ранее результатов, она способна принимать решения и создавать иерархические информационные структуры любой сложности.

В 1939 г. Тьюринг сконструировал электронный калькулятор Bombe, который помогал дешифровать сообщения, составленные немцами на кодирующей машине Enigma. К 1943 г. группа инженеров при участии Тьюринга закончила создание машины Colossus, которую иногда называют первым в истории компьютером. Это позволило союзникам расшифровывать сообщения, созданные более сложной версией Enigma. Машины Bombe и Colossus были сконструированы для решения единственной задачи и не могли перепрограммироваться. Но свою функцию они выполняли блестяще. Считается, что отчасти благодаря им союзники могли предвидеть тактику немцев на протяжении всей войны, а Королевские военно-воздушные силы Великобритании в Битве за Британию смогли одолеть втрое превосходящие их по численности силы Люфтваффе.

Именно на этой основе Джон фон Нейман создал компьютер современной архитектуры, отражающей третью из четырех важнейших идей теории информации. На протяжении прошедших с тех пор почти семидесяти лет основное ядро этой машины, названной «машиной фон Неймана», практически не изменилось - как в микроконтроллере в вашей стиральной машине, так и в самом крупном суперкомпьютере. В статье, опубликованной 30 июня 1945 г. и озаглавленной «Первый проект отчета о EDVAC», фон Нейман изложил основные идеи, которые с тех пор направляли развитие информатики . В машине фон Неймана присутствует центральный процессор, где выполняются арифметические и логические операции, модуль памяти, в котором хранятся программы и данные, массовая память, программный счетчик и входные/выходные каналы. Хотя статья предназначалась для внутреннего пользования в рамках выполнения проекта, для создателей компьютеров она стала Библией. Вот так иногда обычный рутинный отчет может изменить мир.

Машина Тьюринга не была предназначена для практических целей. Теоремы Тьюринга не имели отношения к эффективности решения задач, а скорее описывали спектр задач, которые теоретически могут быть решены с помощью компьютера. Напротив, цель фон Неймана заключалась в создании концепции реального компьютера. Его модель заменила однобитную систему Тьюринга многобитной (обычно кратную восьми битам) системой. Машина Тьюринга имеет последовательную ленту памяти, так что программы затрачивают очень большое время на перемещение ленты вперед и назад для записи и извлечения промежуточных результатов. Напротив, в системе фон Неймана доступ к памяти осуществляется произвольным образом, что позволяет немедленно извлекать любые нужные данные.

Одной из ключевых идей фон Неймана является концепция хранимой программы, которую он развил за десять лет до создания компьютера. Суть концепции заключается в том, что программа хранится в том же модуле памяти с произвольным доступом, что и данные (а часто даже в том же блоке памяти). Это позволяет перепрограммировать компьютер для решения разных задач и создавать самомодифицирующийся код (в случае записывающих накопителей), что обеспечивает возможность рекурсии. До того времени практически все компьютеры, включая Colossus, создавались для решения конкретных задач. Концепция хранимой программы позволила компьютеру стать поистине универсальной машиной, соответствующей представлению Тьюринга об универсальности машинных вычислений.

Еще одно важное свойство машины фон Неймана заключается в том, что в каждой инструкции содержится операционный код, определяющий арифметическую или логическую операцию и адрес операнда в памяти компьютера.

Концепция фон Неймана об архитектуре компьютера отразилась в проекте EDVAC, над которым он работал совместно с Преспером Дж. Эккертом и Джоном Моучли. Компьютер EDVAC начал функционировать только в 1951 г., когда уже существовали другие компьютеры с хранимой программой, такие как Манчестерская малая экспериментальная машина, ENIAC, EDSAC и BINAC, причем все они были созданы под влиянием статьи фон Неймана и при участии Эккерта и Моучли. Фон Нейман также был причастен к появлению некоторых из этих машин, включая последнюю версию ENIAC, где использовался принцип хранимой программы.

У компьютера с архитектурой фон Неймана имелось несколько предшественников, но ни один из них - за одним неожиданным исключением - нельзя назвать истинной машиной фон Неймана. В 1944 г. Говард Эйкен выпустил Mark I, который можно было в какой-то степени перепрограммировать, но он не использовал хранимой программы. Машина считывала инструкции с перфокарты и немедленно их выполняла. В машине также не было предусмотрено условных переходов.

В 1941 г. немецкий ученый Конрад Цузе (1910–1995) создал компьютер Z-3. Он тоже считывал программу с ленты (в данном случае закодированную на пленке) и тоже не выполнял условных переходов. Интересно, что Цузе получил финансовую поддержку от Немецкого института самолетостроения, который использовал этот компьютер для изучения флаттера крыла самолета. Однако предложение Цузе о финансировании замены реле радиолампами не было поддержано нацистским правительством, которое считало развитие компьютерной технологии «не имеющим военного значения». Это, как мне кажется, в определенной степени повлияло на исход войны.

На самом деле у фон Неймана был один гениальный предшественник, причем жил он на сто лет раньше! Английский математик и изобретатель Чарльз Бэббидж (1791–1871) в 1837 г. описал свою аналитическую машину, основанную на тех же принципах , что и компьютер фон Неймана, и использовавшую хранимую программу, нанесенную на перфокарты жаккардовых ткацких машин. Память машины с произвольным доступом содержала 1000 слов по 50 десятичных знаков в каждом (что эквивалентно примерно 21 килобайту). Каждая инструкция содержала код операции и номер операнда - точно так же, как в современных компьютерных языках. Система не использовала условных переходов и циклов, так что это была настоящая машина фон Неймана. Полностью механическая, она, по-видимому, превзошла и дизайнерские, и организаторские возможности самого Бэббиджа. Он создал части машины, но так и не запустил ее.

Точно не известно, знали ли пионеры компьютеростроения XX в., включая фон Неймана, о работах Бэббиджа .

Однако создание машины Бэббиджа положило начало развитию программирования. Английская писательница Ада Байрон (1815–1852), графиня Лавлейс, единственный законный ребенок поэта лорда Байрона, стала первым в мире программистом. Она писала программы для аналитической машины Бэббиджа и отлаживала их в уме (поскольку компьютер так никогда и не заработал). Теперь программисты называют эту практику table checking. Она перевела статью итальянского математика Луиджи Менабреа об аналитической машине, добавив от себя существенные замечания и заметив, что «аналитическая машина плетет алгебраические рисунки, как ткацкий жаккардовый станок плетет цветы и листья». Возможно, она первой упомянула о возможности создания искусственного интеллекта, но сделала вывод, что аналитическая машина «сама не способна что-либо придумать».

Идеи Бэббиджа кажутся поразительными, если учесть, в какую эпоху он жил и работал. Однако к середине XX в. эти идеи были практически забыты (и вновь открыты лишь позднее). Именно фон Нейман придумал и сформулировал ключевые принципы действия компьютера в его современном виде, и недаром машину фон Неймана продолжают считать основной моделью вычислительной машины. Однако не будем забывать, что машина фон Неймана постоянно осуществляет обмен данными между отдельными модулями и внутри этих модулей, так что она не могла быть создана без теорем Шеннона и тех методов, которые он предложил для надежной передачи и хранения цифровой информации.

Все сказанное подводит нас к четвертой важной идее, которая преодолевает выводы Ады Байрон о неспособности компьютера к творческому мышлению и позволяет найти ключевые алгоритмы, используемые мозгом, чтобы потом применить их для превращения компьютера в мозг. Алан Тьюринг сформулировал эту задачу в статье «Вычислительные машины и разум», опубликованную в 1950 г., в которой содержится описание теперь широко известного теста Тьюринга, позволяющего определить близость ИИ к человеческому интеллекту.

В 1956 г. фон Нейман начал готовить серию лекций для престижных Силлимановских чтений в Йельском университете. Ученый уже был болен раком и не смог ни прочесть свои лекции, ни даже закончить рукопись, на основе которой создавались лекции. Тем не менее этот незаконченный труд является блестящим предсказанием того, что лично я воспринимаю как самый трудный и важный проект в истории человечества. Уже после смерти ученого, в 1958 г., рукопись была опубликована под названием «Компьютер и мозг». Так вышло, что последний труд одного из самых блестящих математиков прошлого столетия и одного из основоположников компьютерной технологии оказался посвящен анализу мышления. Это было первое серьезное исследование человеческого мозга с точки зрения математика и специалиста в области компьютеров. До фон Неймана компьютерные технологии и нейробиология представляли собой два отдельных острова, между которыми не существовало никакого моста.

Фон Нейман начинает повествование, описывая сходство и различие между компьютером и человеческим мозгом. Учитывая, в какую эпоху создавался этот труд, он представляется удивительно точным. Ученый отмечает, что выходной сигнал нейрона цифровой - аксон либо возбуждается, либо остается в покое. В то время было далеко не очевидно, что обработка выходного сигнала может происходить аналоговым путем. Обработка сигнала в дендритах, ведущих к нейрону, и в теле нейрона аналоговая, и фон Нейман описал эту ситуацию с помощью взвешенной суммы входных сигналов с пороговым значением.

Эта модель функционирования нейронов привела к развитию коннекционизма и к использованию данного принципа для создания как аппаратурного оформления, так и компьютерных программ. (Как я рассказывал в предыдущей главе, первая такая система, а именно программа для IBM 704, была создана Фрэнком Розенблаттом из Корнельского университета в 1957 г., сразу после того, как стала доступна рукопись лекций фон Неймана.) Теперь у нас есть более сложные модели, описывающие сочетания входных сигналов нейронов, но общая идея об аналоговой обработке сигналов с помощью изменения концентрации нейромедиаторов по-прежнему верна.

На основе концепции универсальности компьютерных вычислений фон Нейман пришел к выводу, что даже при кажущемся радикальном различии архитектуры и структурных единиц головного мозга и компьютера с помощью машины фон Неймана мы можем симулировать происходящие в головном мозге процессы. Обратный постулат, однако, не является справедливым, поскольку головной мозг не является машиной фон Неймана и не имеет хранимой программы (хотя в голове мы можем симулировать действие очень простой машины Тьюринга). Алгоритмы или методы функционирования мозга определены его структурой. Фон Нейман пришел к справедливому заключению, что нейроны могут выучивать соответствующие образы на основании входных сигналов. Однако во времена фон Неймана не было известно, что обучение также происходит путем создания и разрушения контактов между нейронами.

Фон Нейман также указал, что скорость обработки информации нейронами очень низкая - порядка сотни вычислений в секунду, однако мозг компенсирует это тем, что одновременно осуществляет обработку информации во множестве нейронов. Это еще одно очевидное, но очень важное открытие. Фон Нейман утверждал, что все 10 10 нейронов мозга (эта оценка также достаточно точна: по сегодняшним представлениям, в головном мозге содержится от 10 10 до 10 11 нейронов) обрабатывают сигналы в одно и то же время. Более того, все контакты (в среднем от 10 3 до 10 4 на каждый нейрон) обсчитываются одновременно.

Учитывая примитивный уровень развития нейробиологии того времени, оценки и описания функции нейронов, сделанные фон Нейманом, удивительно точны. Однако я не могу согласиться с одним аспектом его работы, а именно с представлением об объеме памяти мозга. Он считал, что мозг запоминает каждый сигнал на всю жизнь. Среднюю продолжительность жизни человека фон Нейман оценивал в 60 лет, что составляет примерно 2 х 10 9 секунды. Если каждый нейрон за одну секунду получает примерно 14 сигналов (что на самом деле на три порядка ниже истинной величины), а всего в головном мозге содержится 10 10 нейронов, выходит, что объем памяти мозга составляет около 10 20 бит. Как я писал выше, мы запоминаем лишь небольшую часть наших мыслей и опыта, но даже эти воспоминания хранятся не как побитовая информация низкого уровня сложности (как в видео), а скорее в виде последовательности образов более высокого порядка.

По мере того как фон Нейман описывает каждый механизм в функции головного мозга, он одновременно демонстрирует, как современный компьютер мог бы осуществить ту же самую функцию, несмотря на кажущееся различие между мозгом и компьютером. Аналоговые механизмы действия мозга можно моделировать с помощью цифровых механизмов, поскольку цифровые вычисления способны моделировать аналоговые значения с любой степенью точности (а точность передачи аналоговой информации в мозге достаточно низкая). Можно также имитировать массивный параллелизм функции мозга, учитывая значительное превосходство компьютеров по скорости серийных вычислений (со времен фон Неймана это превосходство еще более усилилось). Кроме того, мы можем осуществлять параллельную обработку сигналов в компьютерах с помощью параллельно функционирующих машин фон Неймана - именно так действуют современные суперкомпьютеры.

Учитывая способность людей быстро принимать решения при столь низкой скорости работы нейронов, фон Нейман пришел к выводу, что функции головного мозга не могут задействовать длинные последовательные алгоритмы. Когда третий бейс-мен получает мяч и решает бросить его на первую, а не на вторую базу, он принимает это решение за какую-то долю секунды - за это время каждый нейрон едва успевает осуществить несколько циклов возбуждения. Фон Нейман приходит к логичному выводу, что замечательная способность мозга связана с тем, что все 100 млрд нейронов могут обрабатывать информацию одновременно. Как я отмечал выше, зрительная кора делает сложные выводы всего за три или четыре цикла возбуждения нейронов.

Именно значительная пластичность мозга позволяет нам обучаться. Однако компьютер обладает гораздо большей пластичностью - его методы можно полностью изменить путем смены программного обеспечения. Таким образом, компьютер может имитировать мозг, а вот обратное утверждение неверно.

Когда фон Нейман сравнивал возможности массированной параллельной активности мозга с немногочисленными компьютерами того времени, казалось очевидным, что мозг отличается гораздо большей памятью и скоростью. Сегодня уже сконструирован первый суперкомпьютер, по самым консервативным оценкам, удовлетворяющий тем функциональным требованиям, которые нужны для моделирования функций человеческого головного мозга (около 10 16 операций в секунду) . (По моему мнению, компьютеры такой мощности в начале 2020-х гг. будут стоить около 1000 долларов.) Что касается объема памяти, мы продвинулись еще дальше. Труд фон Неймана появился в самом начале компьютерной эры, но ученый был уверен в том, что в какой-то момент мы сможем создавать компьютеры и компьютерные программы, способные имитировать человеческий мозг; именно поэтому он и готовил свои лекции.

Фон Нейман был глубоко убежден в ускорении прогресса и в его значительном влиянии на жизнь людей в будущем. Через год после смерти фон Неймана, в 1957 г., его коллега математик Стэн Юлам цитировал слова фон Неймана, сказавшего в начале 1950-х гг., что «любое ускорение технологического прогресса и изменения образа жизни людей создает впечатление приближения некой важнейшей сингулярности в истории человеческой расы, за пределами которой человеческая деятельность в том виде, какой мы знаем ее сегодня, больше не может продолжаться». Это первый известный случай использования слова «сингулярность» для описания технологического прогресса человечества.

Важнейшая догадка фон Неймана заключалась в обнаружении сходства между компьютером и мозгом. Заметим, что частью человеческого интеллекта является эмоциональный интеллект. Если догадка фон Неймана верна и если согласиться с моим утверждением, что небиологическая система, удовлетворительно воспроизводящая интеллект (эмоциональный и другой) живого человека, обладает сознанием (см. следующую главу), придется сделать вывод, что между компьютером (с правильным программным обеспечением) и сознательным мышлением имеется явное сходство. Итак, был ли прав фон Нейман?

Большинство современных компьютеров - полностью цифровые машины, тогда как человеческий мозг использует как цифровые, так и аналоговые методы. Однако аналоговые методы легко воспроизводятся в цифровом варианте с любой степенью точности. Американский специалист в области компьютерных технологий Карвер Мид (род. в 1934 г.) показал, что аналоговые методы мозга можно напрямую воспроизвести в кремниевом варианте, и реализовал это в виде так называемых нейроморфных чипов . Мид продемонстрировал, что данный подход может быть в тысячи раз более эффективным, чем цифровая имитация аналоговых методов. Если речь идет о кодировании избыточных алгоритмов новой коры, возможно, имеет смысл воспользоваться идеей Мида. Исследовательская группа IBM под руководством Дхармендра Модхи применяет чипы, имитирующие нейроны и их контакты, в том числе их способность образовывать новые контакты . Один из чипов, названный SyNAPSE, напрямую модулирует 256 нейронов и примерно четверть миллиона синаптических связей. Цель проекта заключается в симуляции новой коры, состоящей из 10 млрд нейронов и 100 трлн контактов (что эквивалентно человеческому мозгу), которая использует всего один киловатт энергии.

Более пятидесяти лет назад фон Нейман заметил, что процессы в головном мозге происходят чрезвычайно медленно, но отличаются массированной параллельностью. Современные цифровые схемы действуют как минимум в 10 млн раз быстрее, чем электрохимические переключатели мозга. Напротив, все 300 млн распознающих модулей коры мозга действуют одновременно, и квадрильон контактов между нейронами может активизироваться в одно и то же время. Следовательно, для создания компьютеров, которые могли бы адекватно имитировать человеческий мозг, необходимы соответствующий объем памяти и производительность вычислений. Нет нужды напрямую копировать архитектуру мозга - это очень неэффективный и негибкий метод.

Какими же должны быть соответствующие компьютеры? Многие исследовательские проекты направлены на моделирование иерархического обучения и распознавания образов, происходящих в новой коре. Я сам занимаюсь подобными исследованиями с привлечением иерархических скрытых моделей Маркова. По моим оценкам, для моделирования одного цикла распознавания в одном распознающем модуле биологической новой коры требуется около 3000 вычислений. Большинство симуляций построено на значительно меньшем числе вычислений. Если принять, что головной мозг осуществляет около 10 2 (100) циклов распознавания в секунду, получаем общее число 3 х 10 5 (300 тыс.) вычислений в секунду для одного распознающего модуля. Если же умножить это число на общее число распознающих модулей (3 х 10 8 (300 млн, по моим оценкам)), получаем 10 14 (100 трлн) вычислений в секунду. Примерно такое же значение я привожу в книге «Сингулярность уже близка». По моим прогнозам, для функциональной симуляции головного мозга требуется скорость от 10 14 до 10 16 калькуляций в секунду. По оценкам Ганса Моравека, основанным на экстраполяции данных для начальной обработки зрительных сигналов во всем головном мозге, это значение составляет 10 14 калькуляций в секунду, что совпадает с моими расчетами.

Стандартные современные машины могут работать со скоростью до 10 10 калькуляций в секунду, однако с помощью ресурсов облака их производительность можно существенно увеличить. Самый быстрый суперкомпьютер, японский компьютер «К», уже достиг скорости 10 16 калькуляций в секунду. Учитывая массированную избыточность алгоритмов новой коры, хороших результатов можно добиться с помощью нейроморфных чипов, как в технологии SvNAPSE.

Что касается требований к памяти, нам нужно около 30 бит (примерно 4 байта) для каждого контакта с одним из 300 млн распознающих модулей. Если к каждому распознающему модулю подходит в среднем восемь сигналов, получаем 32 байта на распознающий модуль. Если учесть, что вес каждого входного сигнала составляет один байт, получаем 40 байт. Добавим 32 байта для нисходящих контактов - и получим 72 байта. Замечу, что наличие восходящих и нисходящих разветвлений приводит к тому, что число сигналов намного больше восьми, даже если учесть, что многие распознающие модули пользуются общей сильно разветвленной системой связей. Например, в распознавании буквы «p» могут участвовать сотни распознающих модулей. Это означает, что тысячи распознающих модулей следующего уровня участвуют в распознавании слов и фраз, содержащих букву «p». Однако каждый модуль, ответственный за распознавание «p», не повторяет это древо связей, питающих все уровни распознавания слов и фраз с «p», у всех этих модулей древо связей общее.

Сказанное выше верно и для нисходящих сигналов: модуль, ответственный за распознавание слова apple, сообщит всей тысяче стоящих ниже модулей, ответственных за распознавание «e», что ожидается образ «e», если уже распознаны «a», «p», «p» и «l». Это древо связей не повторяется для каждого модуля, распознающего слово или фразу, который хочет информировать модули нижестоящего уровня, что ожидается образ «e». Это древо общее. По этой причине среднее оценочное значение в восемь восходящих и восемь нисходящих сигналов для каждого распознающего модуля является вполне разумным. Но даже если мы повысим это значение, это не сильно изменит конечный результат.

Итак, с учетом 3 х 10 8 (300 млн) распознающих модулей и 72 байт памяти для каждого, получаем, что общий объем памяти должен составлять около 2 х 10 10 (20 млрд) байт. А это весьма скромное значение. Такой памятью обладают обычные современные компьютеры.

Все эти расчеты мы выполнили для приблизительной оценки параметров. Учитывая, что цифровые схемы примерно в 10 млн раз быстрее сетей нейронов в биологической коре, нам не нужно воспроизводить массированный параллелизм человеческого мозга - весьма умеренного параллельного процессинга (по сравнению с триллионным параллелизмом в головном мозге) будет вполне достаточно. Таким образом, необходимые вычислительные параметры вполне достижимы. Способность нейронов головного мозга к переподключению (помним, что дендриты постоянно создают новые синапсы) тоже можно имитировать с помощью соответствующего программного обеспечения, поскольку компьютерные программы гораздо пластичнее биологических систем, которые, как мы видели, впечатляют, но имеют пределы.

Избыточность мозга, необходимая для получения инвариантных результатов, безусловно, может быть воспроизведена в компьютерном варианте. Математические принципы оптимизации подобных самоорганизующихся иерархических систем обучения вполне понятны. Организация мозга далеко не оптимальна. Но она и не должна быть оптимальной - она должна быть достаточно хорошей, чтобы обеспечить возможность создавать инструменты, компенсирующие ее собственные ограничения.

Еще одно ограничение новой коры заключается в том, что в ней нет механизма, устраняющего или хотя бы оценивающего противоречащие друг другу данные; отчасти это объясняет весьма распространенную нелогичность человеческих рассуждений. Для решения данной проблемы у нас есть весьма слабая способность, называемая критическим мышлением, но люди ею пользуются гораздо реже, чем следовало бы. В компьютерной новой коре можно предусмотреть процесс, выявляющий противоречащие данные для их последующего пересмотра.

Важно отметить, что конструирование целого отдела мозга осуществить проще, чем конструирование одного нейрона. Как уже было сказано, на более высоком уровне иерархии модели часто упрощаются (тут просматривается аналогия с компьютером). Чтобы понять, как работает транзистор, нужно в деталях понимать физику полупроводниковых материалов, а функции одного реального транзистора описываются сложными уравнениями. Цифровая схема, осуществляющая перемножение двух чисел, содержит сотни транзисторов, но для создания модели такой схемы хватит одной или двух формул. Целый компьютер, состоящий из миллиардов транзисторов, можно смоделировать с помощью набора инструкций и описания регистра на нескольких страницах текста с привлечением нескольких формул. Программы для операционных систем, компиляторов языков или ассемблеров достаточно сложны, однако моделирование частной программы (например, программы распознавания языка на основе скрытых иерархических моделей Маркова) тоже сводится к нескольким страницам формул. И нигде в подобных программах вы не встретите детального описания физических свойств полупроводников или даже компьютерной архитектуры.

Аналогичный принцип верен и для моделирования мозга. Один конкретный распознающий модуль новой коры, который детектирует определенные инвариантные зрительные образы (например, лица), осуществляет фильтрацию звуковых частот (ограничивая входной сигнал определенным диапазоном частот) или оценивает временную близость двух событий, можно описать с помощью гораздо меньшего числа специфических деталей, чем реальные физические и химические взаимодействия, контролирующие функции нейромедиаторов, ионных каналов и других элементов нейронов, участвующих в передаче нервного импульса. Хотя все эти детали необходимо тщательно предусмотреть до перехода на следующий уровень сложности, при моделировании операционных принципов головного мозга многое можно упростить.

| <<< Назад

|

Вперед >>>

|

Несмотря на все усилия, неврологи и когнитивные психологи никогда не найдут в мозге копии Пятой симфонии Бетховена, слов, картинок, грамматических правил или любых других внешних сигналов. Конечно же, мозг человека не совсем уж пустой. Но он не содержит большинства вещей, которые, по мнению людей, в нем содержатся - даже таких простых вещей, как «воспоминания».

Наше ложное представление о мозге имеет глубокие исторические корни, но особенно запутало нас изобретение компьютеров в 1940-х годах. На протяжении полувека психологи, лингвисты, нейрофизиологи и другие эксперты по вопросам человеческого поведения утверждали, что человеческий мозг работает подобно компьютеру.

Чтобы представить, насколько легкомысленна эта идея, рассмотрим мозг младенцев. Здоровый новорожденный обладает более чем десятью рефлексами. Он поворачивает голову в том направлении, где ему чешут щечку, и всасывает все, что попадает в рот. Он задерживает дыхание при погружении в воду. Он так сильно хватает вещи, попавшие ему в руки, что почти может удерживать свой собственный вес. Но, возможно, важнее всего то, что новорожденные обладают мощными механизмами обучения, позволяющими им быстро изменяться, чтобы они могли более эффективно взаимодействовать с окружающим миром.

Чувства, рефлексы и механизмы обучения - это то, что есть у нас с самого начала, и, если задуматься, это достаточно много. Если бы нам не хватало каких-либо из этих способностей, наверное, нам было бы трудно выжить.

Но вот, чего в нас нет с рождения: информации, данных, правил, знаний, лексики, представлений, алгоритмов, программ, моделей, воспоминаний, образов, процессоров, подпрограмм, кодеров, декодеров, символов и буферов - элементов, которые позволяют цифровым компьютерам вести себя в какой-то степени разумно. Мало того, что этих вещей нет в нас с рождения, они не развиваются в нас и при жизни.

Мы не храним слова или правила, говорящие нам, как ими пользоваться. Мы не создаем образы визуальных импульсов, не храним их в буфере кратковременной памяти и не передаем затем образы в устройство долгосрочной памяти. Мы не вызываем информацию, изображения или слова из реестра памяти. Все это делают компьютеры, но не живые существа.

Компьютеры в буквальном смысле слова обрабатывают информацию - цифры, слова, формулы, изображения. Сначала информация должна быть переведена в формат, который может распознать компьютер, то есть в наборы единиц и нулей («битов»), собранные в небольшие блоки («байты»).

Компьютеры перемещают эти наборы с места на место в различные области физической памяти, реализованной в виде электронных компонентов. Иногда они копируют наборы, а иногда различными способами трансформируют их - скажем, когда вы исправляете ошибки в рукописи или ретушируете фотографию. Правила, которым следует компьютер при перемещении, копировании или работе с массивом информации, тоже хранятся внутри компьютера. Набор правил называется «программой» или «алгоритмом». Совокупность работающих вместе алгоритмов, которую мы используем для разных целей (например, для покупки акций или знакомств в интернете) называется «приложением».

Это известные факты, но их нужно проговорить, чтобы внести ясность: компьютеры работают на символическом представлении мира. Они действительно хранят и извлекают. Они действительно обрабатывают. Они действительно имеют физическую память. Они действительно управляются алгоритмами во всем без исключения.

При этом люди ничего такого не делают. Так почему так много ученых говорит о нашей умственной деятельности так, как если бы мы были компьютерами?

В 2015 году эксперт по искусственному интеллекту Джордж Заркадакис выпустил книгу «По нашему образу», в которой он описывает шесть различных концепций, используемых людьми в течение последних двух тысяч лет для описания устройства человеческого интеллекта.

В наиболее ранней версии, изложенной в Библии, люди были созданы из глины или грязи, которую разумный Бог затем пропитал своим духом. Этот дух и «описывает» наш разум - по крайней мере, с грамматической точки зрения.

Изобретение гидравлики в III веке до нашей эры стало причиной популярности гидравлической концепции человеческого сознания. Идея состояла в том, что ток различных жидкостей в теле - «телесных жидкостей» - приходится и на физические, и на духовные функции. Гидравлическая концепция существовала на протяжении более чем 1600 лет, все это время затрудняя развитие медицины.

К XVI веку появились устройства, приводимые в действие пружинами и зубчатыми передачами, что вдохновило Рене Декарта на суждения о том, что человек - это сложный механизм. В XVII веке британский философ Томас Гоббс предположил, что мышление происходит благодаря небольшим механическим движениям в мозгу. К началу XVIII века открытия в области электричества и химии привели к появлению новой теории человеческого мышления, опять-таки имеющей больше метафорический характер. В середине XIX века немецкий физик Герман фон Гельмгольц, вдохновленный последними достижениями в области связи, сравнил мозг с телеграфом.

Альбрехт фон Галлер. Icones anatomicae

Математик Джон фон Нейман заявил, что функция человеческой нервной системы является «цифровой при отсутствии доказательств в пользу противного», проводя параллели между компонентами компьютерных машин того времени и участками человеческого мозга.

Каждая концепция отражает самые передовые идеи породившей её эпохи. Как и следовало ожидать, всего через несколько лет после зарождения компьютерных технологий в 1940-х годах стали утверждать, что мозг работает, как компьютер: роль физического носителя играл сам мозг, а наши мысли выступали в качестве программного обеспечения.

Такая точка зрения достигла максимального развития в книге «Компьютер и мозг» 1958 года, в которой математик Джон фон Нейман решительно заявил, что функция нервной системы человека является «цифровой при отсутствии доказательств в пользу противного». Хоть он и признавал, что о роли мозга в работе интеллекта и памяти известно очень мало, ученый проводил параллели между компонентами компьютерных машин того времени и участками человеческого мозга.

Изображение: Shutterstock

Благодаря последующим достижениям в области компьютерных технологий и исследования мозга, постепенно развивалось амбициозное междисциплинарное учение о человеческом сознании, в основе которого лежит идея о том, что люди, как и компьютеры - это информационные процессоры. Эта работа в настоящее время включает в себя тысячи исследований, получает миллиарды долларов финансирования, и становится темой для множества трудов. Книга Рэя Курцвейла «Как создать разум: Раскрытие тайны человеческого мышления», выпущенная в 2013 году, иллюстрирует эту точку зрения, описывает «алгоритмы» мозга, методы «обработки информации» и даже то, как он внешне напоминает в своей структуре интегральные схемы.

Представление о человеческом мышлении как об устройстве обработки информации (ОИ) в настоящее время доминирует в человеческом сознании как среди обычных людей, так и среди ученых. Но это, в конце концов, просто еще одна метафора, вымысел, который мы выдаем за действительность, чтобы объяснить то, что на самом деле не понимаем.

Несовершенную логику концепции ОИ довольно легко сформулировать. Она основана на ошибочном силлогизме с двумя разумными предположениями и неверным выводом. Разумное предположение №1: все компьютеры способны на разумное поведение. Разумное предположение №2: все компьютеры являются информационными процессорами. Неверное заключение: все объекты, способные вести себя разумно - информационные процессоры.

Если забыть о формальностях, то идея о том, что люди должны быть информационными процессорами, только потому, что компьютеры являются таковыми – это полная глупость, и когда от концепции ОИ окончательно откажутся, наверняка историками она будет рассматриваться с этой же точки зрения, как сейчас для нас выглядят чушью гидравлическая и механическая концепции.

Проведите эксперимент: нарисуйте сторублевую купюру по памяти, а потом достаньте ее из кошелька и скопируйте. Видите разницу?

Рисунок, сделанный в отсутствие оригинала, наверняка окажется ужасен в сравнении с рисунком, сделанным с натуры. Хотя вообще-то вы видели эту купюру не одну тысячу раз.

В чем проблема? Разве «образ» банкноты не должен «храниться» в «запоминающем регистре» нашего мозга? Почему мы не можем просто «обратиться» к этому «образу» и изобразить его на бумаге?

Очевидно, нет, и тысячи лет исследований не позволят определить расположение образа этой купюры в мозге человека просто потому, что его там нет.

Продвигаемая некоторыми учеными идея о том, что отдельные воспоминания каким-то образом хранятся в специальных нейронах, абсурдна. Помимо прочего эта теория выводит вопрос об устройстве памяти на еще более неразрешимый уровень: как и где тогда память хранится в клетках?

Сама идея того, что воспоминания хранятся в отдельных нейронах, абсурдна: как и где в клетке может храниться информация?

Нам никогда не придется беспокоиться о том, что человеческий разум выйдет из-под контроля в киберпространстве, и нам никогда не удастся достичь бессмертия, скачав душу на другой носитель.

Одно из предсказаний, которое в том или ином виде высказывали футуролог Рэй Курцвейл, физик Стивен Хокинг и многие другие, заключается в том, что если сознание человека подобно программе, то скоро должны появиться технологии, которые позволят загрузить его на компьютер, тем самым многократно усилив интеллектуальные способности и сделав возможным бессмертие. Эта идея легла в основу сюжета фильма-антиутопии «Превосходство» (2014), в котором Джонни Депп сыграл ученого, похожего на Курцвейла. Он загрузил свой разум в интернет, чем вызвал разрушительные последствия для человечества.

Кадр из фильма «Превосходство»

К счастью, концепция ОИ даже близко не имеет ничего общего с действительностью, так что нам не стоит волноваться о том, что человеческий разум выйдет из-под контроля в киберпространстве, и, как это ни прискорбно, нам никогда не удастся достичь бессмертия, скачав душу на другой носитель. Дело не только в отсутствии какого-то ПО в мозге, проблема здесь еще глубже – назовем ее проблемой уникальности, и она одновременно восхищает и угнетает.

Поскольку в нашем мозге нет ни «запоминающих устройств», ни «образов» внешних раздражителей, а в ходе жизни мозг меняется под действием внешних условий, нет повода считать, что любые два человека в мире реагируют на одно и то же воздействие одинаково. Если вы и я посетим один и тот же концерт, изменения, которые произойдут в вашем мозге после прослушивания, будут отличаться от изменений, которые произойдут в моем мозге. Эти изменения зависят от уникальной структуры нервных клеток, которая формировалась в ходе всей предыдущей жизни.

Именно поэтому, как написал Фредерик Бартлетт в 1932 году в книге «Память», два человека, услышавшие одну и ту же историю, не смогут пересказать ее полностью одинаково, а со временем их версии истории будут все меньше походить друг на друга.

«Превосходство»

По-моему, это очень вдохновляет, ведь это значит, что каждый из нас по-настоящему уникален, не только по набору генов, но и по тому, как меняется наш мозг со временем. Однако это также и угнетает, ведь это делает и без того трудную работу нейробиологов практически неразрешимой. Каждое изменение может затронуть тысячи, миллионы нейронов или весь мозг целиком, причем природа этих изменений в каждом случае тоже уникальна.

Хуже того, даже если бы мы смогли записать состояние каждого из 86 миллиардов нейронов мозга и сымитировать все это на компьютере, эта громадная модель оказалась бы бесполезной вне тела, которому принадлежит данный мозг. Это, пожалуй, самое досадное заблуждение об устройстве человека, которым мы обязаны ошибочной концепции ОИ.

В компьютерах хранятся точные копии данных. Они могут оставаться без изменений долгое время даже при отключении питания, в то время как мозг поддерживает наш интеллект, только пока он остается живым. Нет никакого рубильника. Либо мозг будет работать без остановки, либо нас не станет. Более того, как отметил нейробиолог Стивен Роуз в 2005 году в работе «Будущее мозга», копия текущего состояния мозга может быть бесполезна и без знания полной биографии его владельца, даже включая социальный контекст, в котором рос человек.

Тем временем огромные средства расходуются на исследования мозга, основанные на ложных идеях и обещаниях, которые не будут исполнены. Так, в Евросоюзе был запущен проект исследования человеческого мозга стоимостью $1,3 млрд. Европейские власти поверили заманчивым обещаниям Генри Маркрэма создать к 2023 году действующий симулятор работы мозга на базе суперкомпьютера, который бы в корне изменил подход к лечению болезни Альцгеймера и других недугов, и обеспечили проекту практически безграничное финансирование. Меньше чем через два года после запуска проекта он обернулся провалом, и Маркрэма попросили уйти в отставку.

Люди – это живые организмы, а не компьютеры. Примите это. Нужно продолжать тяжелую работу по пониманию самих себя, но не тратить время на ненужный интеллектуальный багаж. За полвека существования концепция ОИ дала нам всего несколько полезных открытий. Настало время .

blackhack.ru ОК. Настройки, новости, игры.

blackhack.ru ОК. Настройки, новости, игры.